Vor 26 Jahren erlang Deep Blue, einem Schachcomputer von IBM (Titelbild), den Sieg über den Schachgrossmeister Gerry Kasparov. Der Sieg war symbolisch, denn nie zuvor war es einer künstlichen Intelligenz gelungen, einen Menschen in einem Spiel zu besiegen in welchem es nicht in erster Linie um Geschwindigkeit oder Präzision geht, sondern um strategisches Denken und Taktik.

Dieser Artikel ist länger und geht weiter in die Tiefe als unsere üblichen Beiträge - passend als Lektüre über die Feiertage 🎄

Kühle Köpfe

Zu dieser Zeit kannte man Computer als kühle Kalkulationsmaschinen, die zwar schnell rechnen und kommunizieren konnten, passend für Finanztransaktionen, Aerodynamiksimulationen, oder zur Steuerung von Raketen, jedoch unvorstellbar für Tätigkeiten wie dem Denken, so dachte man, die dem Menschen so eigen sind.

Heute ist das anders. Mit dem Sieg von AlphaGo gegen den Weltbesten im Brettspiel Go in 2016, autonomen Autos und ChatGPT gilt KI heute als Deus Ex Machina, einem Geist welcher offenbar jede Menschliche Tätigkeit in Windeseile übernehmen kann, weit entfernt vom kalten, kalkulierenden Rechner der 1990er Jahre. Fällt in einer Diskussion einmal der Begriff der KI, verliert diese meist schnell den Boden, Fakten mischen sich mit Meinungen, Hoffnungen mit Ängsten 1.

Man könnte denken, dass ein Mensch 26 Jahre nach Deep Blue erst recht nichts mehr gegen die Übermacht einer Schach-KI etwas ausrichten kann. In einem 1 gegen 1 Wettkampf ist dies zwar wahr, wenn jedoch ein mittelwertiger Schachcomputer und ein Mensch im Team spielen, können die beiden auch die stärksten Schachcomputer schlagen 2.

Es zeigt sich, dass Schachcomputer seit Deep Blue taktisch zwar sehr geschickt sind und im Gegensatz zu Menschen keine Flüchtigkeitsfehler machen, sie jedoch grosse Mühe haben, langfristig zu denken, d.h. eine Strategie zu führen. Wenn ein Mensch nun den strategischen Teil übernimmt und der KI die Taktik überlässt, ist diese Kombination, zumindest im Schachspiel sehr schwer zu schlagen.

Strategie versus Taktik

Erstaunlicherweise ist das “Strategieproblem” kein Neues. Während die Geschichte von Deep Blue gegen den russischen Schachgrossmeister jedem Studenten künstlicher Intelligenz bekannt ist, ist es die folgende nicht. Während dem Spiel unternahmen Informatiker von IBM umfangreiche Änderungen an Deep Blue. Sie korrigierten Fehler und passten den Spielstil von Deep Blue demjenigen von Kasparov an. Mit anderen Worten - sie übernahmen die Strategie von Deep Blue. Während Deep Blue Taktik beherrschte, scheiterte es in der Strategie. Als Kasparov IBM um einem Nachspiel bat, lehnte IBM ab.

Auch in heutigen KI-Modellen abseits aktueller Schach-KIs scheint Strategie eine Schwäche zu sein. Auch wenn ChatGPT und Co. eloquent Texte formulieren, können sie alleine kein Buch schreiben. KI-Entwickler nennen diese Modelle deshalb stochastische Papageien.

Softwareentwickler erleben ein ähnliches Phänomen beim Programmieren. KI-Assistenten können zwar kurze Codeblöcke schreiben und passen diese meist auch richtig am Kontext an, aber können lange keine Software, geschweige denn Plattformen bauen (sonst ginge uns bei Algolas schnell die Arbeit aus!). Beim Entwurf der Software und den Entscheidungen, was sie wie tun soll, helfen aktuelle KI-Modelle kaum bis gar nicht.

Mit anderen Worten haben aktuelle KI-Modelle zwar die Taktik im Griff, tun sich aber schwer mit Strategie. Warum ist das so?

Warum Strategie schwer ist

Typischerweise wird nun folgendes Argument angebracht: entwickle und trainiere eine neue KI die sich auf Strategie spezialisiert, und benutze diese als Strategie-Modul mit anderen, auf die Aufgabe spezialisierte KIs zusammen.

Dieses Argument hat jedoch zwei Schwächen: viele Freiheitsgrade und die Abhängigkeit von Details.

Freiheitsgrade

Zum einen setzt es voraus, dass strategisches Denken sich ähnlich definieren lässt wie ein Brettspiel, oder einem Text. Bei beiden ist die Anzahl Handlungen zu einem Zeitpunkt stark begrenzt und klar abgegrenzt. Bei einem Brettspiel sind es die nächsten möglichen Spielzüge, bei einem Text das nächste Wort. Welche sind die möglichen Handlungen beim Gründen eines Unternehmens? Und welche beim Entwickeln einer Online-Plattform?

Die Anzahl Freiheitsgrade bei Handlungen in der echten Welt ist bedeutend grösser als bei einem Brettspiel, oder während dem Verfassen eines Textes. Trotz der vielen Freiheitsgrade können Menschen erstaunlich gut damit umgehen. Die Fähigkeit dazu wird gerne als “Intuition” zusammengefasst und besteht wahrscheinlich aus einer Mischung von vielen einzelnen Erfahrungen und Lernvorgängen in unserem Gehirn. Auch wenn die Forschung seit AlphaGo einen grossen Schritt in Richtung “künstlicher Intuition” gekommen ist, ist das Ziel noch nicht erreicht.

Abhängigkeit von Details

Zum anderen impliziert das Argument, dass die Strategie unabhängig der Taktik geführt werden kann, dass das Strategie-Modul also keine Details über die Aufgabe kennen muss. Im strategischen Denken ist aber das Erkennen und Verstehen von Zusammenhängen, auch von Details, wichtig. Bereits der Chaostheorie3 wussten Militärstrategen, dass auch scheinbar unwichtige Einzelheiten für die Schlacht entscheidend sein können.

Ein Strategie-Modul also unabhängig von Modellen zu trainieren, die auf die Aufgabe spezialisiert sind ist also wenig erfolgsversprechend. Hier kommen die beiden Schwächen zusammen: wenn sehr viele Freiheitsgrade auftreten, reicht keine Rechenkapazität der Welt mehr aus, die richtige Entscheidung zu treffen. Indem aber Zusammenhänge und langfristiges Denken eingebracht werden, fallen viele Freiheitsgrade weg. Aus einzelnen Spielzügen entsteht Taktik, und aus Taktiken wird Strategie. Noch sind wir aber nicht so weit.

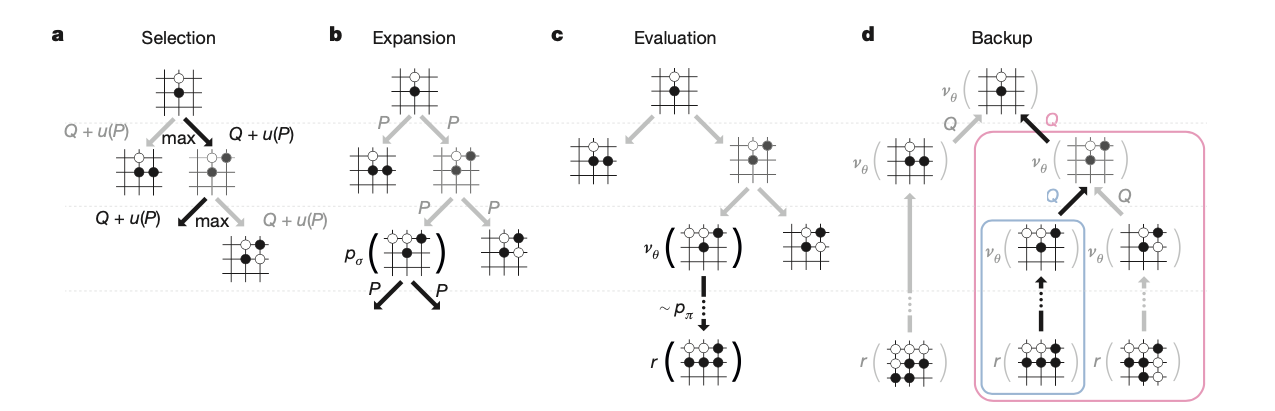

AlphaGo simuliert mögliche Spielpositionen und bewertet diese um dann die meistversprechendste zu wählen.

Der Weg in die Zukunft

Strategie ist also schwierig in KI-Modellen zu implementieren. Gleichzeitig ist sie ein notwendiger Baustein auf dem Weg zu allgemeiner künstlicher Intelligenz (artificial general intelligence, AGI), also einer KI die nicht nur in einzelnen Aufgaben gut ist, sondern sich auf verschiedene Problemstellungen anpassen kann. Auch wenn KI Probleme angehen soll die weitreichender sind als das Verfassen eines Textes, oder dem Go-Spiel, wird strategisches Denken notwendig.

Was bedeutet das nun? Wir denken an zwei Richtungen: neue Architekturen und dem pragmatischen Einsatz der KI in Bereichen, wo sie stark ist.

Eine neue Architektur

Aktuelle KI-Modelle wie z.B. ChatGPT benutzen den sogenannten Attention- oder Aufmerksamkeits-Mechanismus, unter anderem um Zusammenhänge zu erkennen. Während dieser Mechanismus Modellen zu einem riesigen Leistungssprung verholfen hat, verfügt auch dieser über eine begrenzte “Aufmerksamkeitsspanne”, auch Kontextfenster genannt. Bei OpenAI’s neuestem GPT-4 beträgt dieses Kontextfenster 8000 Zeichen, erweiterbar auf 32’000 Zeichen (dieser Beitrag besteht aus x Zeichen).

Bedenkt man dass Text eine eher spärliche Informationsdichte hat (der deutschsprachige Wikipedia-Artikel von Gerry Kasparov verfügt über ca. 33’000 Zeichen), ist die “Aufmerksamkeitsspanne” eines Sprachmodells schnell aufgebraucht, bzw. mehrfach überschritten. Mit Text fällt es dem Modell zudem leicht, die “Aufmerksamkeit” zu dosieren. Es kann den Text Zeichen für Zeichen in sein Kontextfenster laden und muss keine Priorisierung vornehmen, oder sich nur relevante Textstellen oder gar Konzepte zu merken 4.

Es gilt also, wie auch bei uns, die Aufmerksamkeit clever einzusetzen. Einen Weg dazu gibt uns die Neurowissenschaft: Hierarchie und Unterteilung 3.

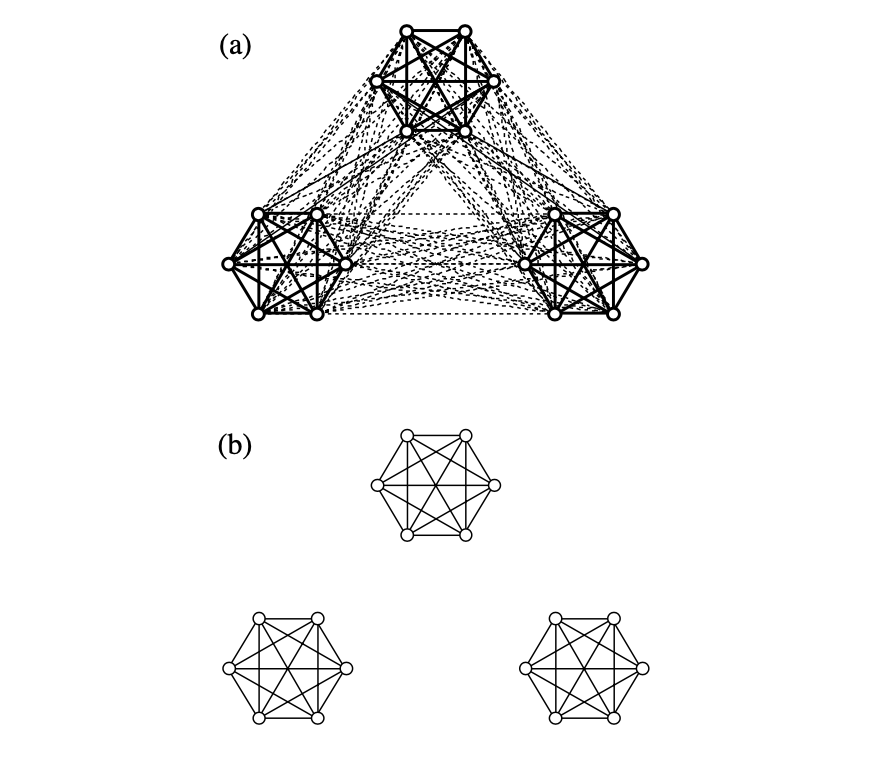

Unterteilte neuronale Netze finden einen Mittelweg zwischen Modularisierung und Holistik. (a) die einzelnen neuronalen Netze sind untereinander schwächer verbunden. (b) die einzelnen Netze. Bildquelle: Dynamics of Complex Systems3

Hierarchie und Unterteilung

Hierarchie bedeutet hier, Problemstellungen in kleinere zu unterteilen, und diese einzeln zu lösen. Idealerweise wird dieses Vorgehen in der Architektur eines Modells gespiegelt. So ist das menschliche Hirn in verschiedene Regionen unterteilt, die jeweils spezifische Funktionen wahrnehmen, ähnlich wie es KI-Modelle mit sehr speziellen Fähigkeiten (z.B. Schach spielen) gibt.

Die Parallelen hören jedoch an einem Punkt auf: Aktuelle KI-Modelle haben keine gemeinsame Sprache, mit welcher sie untereinander kommunizieren können, während Hirnregionen untereinander verbunden sind.

Warum macht das Sinn? Stelle man sich eine Anweisung in zwei Sprachen vor: “Ein Eis bitte”, und “May I have an icecream, please”. Ohne Unterteilung müssten nun zwei Modelle trainiert werden, ein deutsches und ein englisches, welche die Anweisung in eine Aktion umwandeln.

Die Modelle unterscheiden sich nur in kleinen Teilen, das logische Denken ist bei beiden Modellen identisch, besetzt jedoch einen Grossteil der Rechen- und Speicherkapazität ohne zusätzlichen Nutzen. Bei zwei Sprachen ist der Verlust verkraftbar, was ist aber, wenn neben Sprachen noch weitere Eigenschaften kommen? Zum Beispiel gäbe es dann ein deutsches und ein englisches Schachmodell, und wenn zusätzlich Mathematik hinzukommt, muss für jede Sprache wieder ein eigenes Mathematik-Modell trainiert werden.

Lagert man stattdessen das logische Denken in ein eigenes Modell aus und benutzt einzelne Modelle für das Sprachverständnis, werden diese Modelle bedeutend kleiner und können modular erweitert werden.

Aktuell ist noch nicht klar, wie die Kommunikation zwischen diesen Modellen funktionieren könnte. Modelle von verschiedenen Entwicklern könnten so nach belieben kombiniert werden, und grosse, monolithische Modelle ersetzen.

Was bedeutet das für Strategie? Mit Unterteilung könnte das elusive Strategie-Modul in greifbare Nähe gelangen. Durch schwache Verbindungen zu spezialisierten Modellen könnte es Zusammenhänge erkennen. Und statt seine Aufmerksamkeitsspanne für Details aufzuwenden, würde es abstrakte Konzepte verarbeiten.

KI für die Taktik

Noch gibt es kaum Architekturen, welche die oben genannten Eigenschaften erfüllen. Auch wenn KI-Entwickler die Zeitspanne zwischen Forschungsresultaten und Praxiseinsatz mittlerweile auf weniger als ein Jahr bringen, gilt es für die Industrie vorerst praktische Lösungen mit den aktuellen Modellen umzusetzen.

Eine davon ist, aktuelle KI-Modelle für die Dinge einzusetzen, wo sie brillieren, also beim Schreiben kurzer Codestücke, Zusammenfassen oder Verfassen von kurzen Texten, oder beim Übersetzen zwischen Formaten. Kurz: den KI-Modellen die Taktik überlassen, und die Strategie den Menschen, oder herkömmlichen Algorithmen, die von Menschen geschrieben wurden.

-

Grosse Sprachmodelle (LLMs) als Schnittstelle: Computer erwarten Daten in einem strukturierten Format. Weichen die Daten davon ab, müssen die Abweichungen von Entwicklern vorhergesehen, und in Software manuell umgesetzt werden.

LLMs erlauben es nun, Daten entweder ganz unstrukturiert, oder mit imperfekter Struktur zu verarbeiten und in ein strukturiertes Format zu überführen, wie dieses Beispiel zeigt:

Anweisung: Konvertiere folgenden Text in eine maschinenlesbare Liste in dem Format:

{ "Film": "Filmname", "Regie": "Name des Regisseurs", "Jahr": "1970", "Schauspieler": ["A", "B"] }Daten: Pulp Fiction ist ein Gangsterfilm aus dem Jahr 1994 von Quentin Tarantino mit John Travolta und Samuel L. Jackson.

Sprachmodell:

{ "Film": "Pulp Fiction", "Regie": "Quentin Tarantino", "Jahr": "1994", "Schauspieler": ["John Travolta", "Samuel L. Jackson"] } -

KI-Modelle mittels herkömmlicher Algorithmen und transparenten Datenstrukturen zusammenzuführen: So konnten wir in einer Semesterarbeit ein Modell, dass Objekte aus Bildern erkennt, mit einem Sprachmodell verbinden 5. Die erkannten Objekte in den Bildern werden in natürlicher Sprache in eine von Menschen lesbare Struktur gespeichert und anschliessend vom Sprachmodell interpretiert.

So kann zum Beispiel ein Videostream einer Überwachungskamera als eine Art Protokoll in Textform gespeichert werden. Ein Sprachmodell kann dann Fragen beantworten wie: “Wer befand sich um 14:15 in der Nähe des Van-Gogh Gemäldes?”

OpenAI’s neuestes Modell, Q*, scheint mit Planning genau einen solchen Ansatz zu verwenden, wie wir in einem anderen Beitrag beschreiben. Planning ist nichts weiter, als ein herkömmlicher, transparenter Algorithmus, um langfristig und strategisch zu planen.

-

Artificial Intelligence Augmentation: Angefangen mit grafischen Benutzeroberflächen, Computermäusen bis hin zu Smartphones dienen uns Computer nicht nur als Rechenmaschinen, sondern als Erweiterung unseres Gedächtnisses, zur Kommunikation, oder zum Wissenstransfer.

KI fügt sich passend in diese Kette ein, indem es uns zwar nicht alle Arbeit abnimmt, unsere Fähigkeiten aber erweitert. Ein typisches Beispiel für diese sogenannte “Künstliche Intelligenzerweiterung” (englisch Artificial Intelligence Augmentation, AIA) sind Plug-Ins, die uns Codestücke schreiben und vervollständigen, oder uns helfen, die passende Formulierung in einem E-Mail zu finden.

Es gilt nun abzuklären, wo solche Intelligenzerweiterungen noch nutzbringend eingesetzt werden können. Microsoft scheint mit den kommenden Windows-Versionen solche Anwendungsfälle einzuführen.

Fazit

KI ist sowohl in der Forschung wie auch in der Anwendung hochaktuell. Strategie und langfristiges Denken ist jedoch seit der frühen KI-Forschung eine Schwachstelle geblieben.

Eine Lösung die bisher erfolgversprechend war, nämlich immer grössere Modelle zu bauen, scheint in diesem Fall nicht aufzugehen. Es heisst also, tiefer in die Trickkiste zu greifen und neue Ideen zu erproben, sowohl in der Forschung wie auch in der Anwendung.

Einige davon können bereits heute eingesetzt werden, andere sind reine Konzepte, die in Praxis umgesetzt werden müssen.

Bei Algolas verfolgen wir pragmatische Ansätze, die nicht sehr unterschiedlich auch von grossen KI-Forschungszentren erprobt werden. Damit KI nicht nur ein Modebegriff bleibt, sondern auch echten Nutzen bringt.

Notiz zum Einsatz von KI

Unsere Beiträge, wie auch dieser, schreiben wir vollständig selbst. Wo immer wir KI, wie z.B. LLMs benutzen, erwähnen wir dies explizit.

Referenzen

-

Entwickler künstlicher Intelligenz wie Andrej Karpathy, oder Sam Altman von OpenAI hüten sich davor, genaue Voraussagen zur KI zu machen. Beratungsunternehmen zeigen währenddessen weniger Demut: PwC’s Global Artificial Intelligence Study ↩

-

M. Nielsen, Reinventing Discovery ↩

-

Y. Bar-Yam, Dynamics of Complex Systems ↩ ↩2 ↩3

-

Wissen lässt sich auch in einer nicht-textuellen Form darstellen: Thoughts as Computation ↩

-

Y. Antille und M. Solèr, OIC: Object Identification using Context for Temporal Tracking in Dynamic Environments ↩